|

Инфраструктура

В 2010 году в НИЦ "Курчатовский институт" был создан Центр обработки данных (ЦОД) Курчатовского комплекса НБИКС-природоподобных технологий нового поколения, преобразованный в 2018 г. в Объединенный вычислительный кластер (ОВК), включающий четыре конструктивных модуля по 350 м2, обеспечивающих различные условия надежности, специфицированные по уровням используемой инфраструктуры. В нем эксплуатируются стойки с энергопотреблением 6 кВт, 22 кВт и 33 кВт. Используются как классические системы горячих и холодных коридоров, так и системы с изолированным "горячим коридором" на основе межрядных водных кондиционеров, холодопроизводительность одного блока которых составляет от 350 до 450 кВт. Электроснабжение обеспечивают 6 трансформаторов мощностью 2,5 МВА каждый и источники бесперебойного питания мощностью 400 кВА и 500 кВА.

Система холодоснабжения ОВК построена на основе двух моноблочных чиллерных групп, по 3 чиллера мощностью 900 кВт в каждой группе. Чиллеры могут работать в режиме каскадного фрикулинга, что позволяет объединить их холодопроизводительность. Общая производительность системы охлаждения – до 1000 м3 охлаждающей жидкости в час.

Инженерная инфраструктура обслуживает все вычислительные системы ОВК.

Инженерная инфраструктура обслуживает все вычислительные системы ОВК.

Объединенный вычислительный кластер включает в себя многофункциональный вычислительный комплекс (МФК), состоящий из нескольких суперкомпьютеров, многоцелевой аппаратно-программный комплекс для моделирования, хранения, обработки и анализа данных (АПК) и крупнейший в России Грид-центр глобальной грид-инфраструктуры WLCG Большого адронного коллайдера (ЦЕРН, Швейцария), в состав которой входят ресурсы уровней Tier-1 и Tier-2.

ОВК предоставляет свои вычислительные ресурсы организациям и подразделениям НИЦ "Курчатовский институт", а также другим организациям, работающим в различных областях науки, техники и индустрии.

МФК спроектирован, сопровождается и развивается сотрудниками отдела перспективных компьютерных систем и технологий отделения Объединенного вычислительного кластера.

Здесь проводятся исследования в следующих областях:

- технологии системного администрирования и управления большими вычислительными комплексами,

- распределенные системы и вычисления,

- облачные технологии,

- высокопроизводительные системы,

- безопасность и защита вычислительных комплексов,

- пользовательские интерфейсы к вычислительным ресурсам,

- визуализация научных данных.

Расширение предметных областей, в которых выполняются моделирование и анализ данных, выдвинуло новые требования к аппаратно-программному обеспечению ОВК и потребовало проведения его модернизации. В 2010 году в ОВК была реализована концепция аппаратно-программного комплекса (АПК), то есть конгломерата кластеров различного размера, предназначенных для решения специализированных задач, интегрирующихся в единое целое общей фабрикой передачи сообщений и параллельной файловой системой.

АПК состоит из следующих ресурсов:

• кластера HPC3: 16 двухпроцессорных узлов на базе Intel Xeon X5650;

• кластера HPC3G: 80 счётных узлов, оборудованных графическими ускорителями Nvidia Tesla M2070 (3 штуки на узел);

• кластера HPC3V: оборудованного специализированными видеокартами NVidia Quadro 6000, с 12-ю 55-дюймовыми панелями высокого разрешения;

• кластера SMP3: 2 узла с 40 ядрами и 0.5 ТБ оперативной памяти на машину;

• системы хранения данных LS3 суммарного объёма 960 ТБ.

Среда для передачи сообщений и высокоскоростного обмена данных – InfiniBand QDR.

Наличие таких ресурсов позволило организовывать целые конвейеры для проведения численных экспериментов и моделирования, требующих связанных друг с другом, но разнородных по своему характеру расчётов. Ресурсы АПК используются для решения множества различных задач, в частности, ПО для сборки и анализа геномных последовательностей (SMP-машины и кластер HPC3), проведение геопространственного моделирования и решения обратных задач геофизики (кластер HPC3G), система рендеринга изображений с фотореалистичной точностью (кластеры HPC3G и HPC3), видеостена WV3 для презентаций и анализа изображений сверхвысокого разрешения (кластер HPC3V), ресурсы для лаборатории больших данных КК НБИКС-т (кластер HPC3), собственные сервисы для анализа и хранения данных, основанные на технологиях семейства NoSQL (кластер HPC3 и СХД LS3), множественные хранилища под отдельные проекты (СХД LS3). Также ресурсы АПК использовались и используются для организации программно-аппаратных окружений для разработки и тестирования в проектах "Виртуальный суперкомпьютер", построении Tier-1, цикле работ по большим данным.

В конце 2013 года были начаты работы по проектированию новых суперкомпьютерных комлексов, поскольку кластеры HPC2 и АПК круглосуточно загружены не менее, чем на 97 процентов своих мощностей и пользователи часто долго ожидают своей очереди на выполнение вычислительных задач. Кластеры HPC4/HPC5 проектировались как единая система, объединённая фабрикой передачи данных стандарта InfiniBand FDR и высокопроизводительной параллельной файловой системой на базе Lustre, способной показывать скорости чтения/записи не менее 40 ГБайт/сек (для сравнения, Lustre на кластере HPC2 проектировалась на скорость 2 ГБайт/сек).

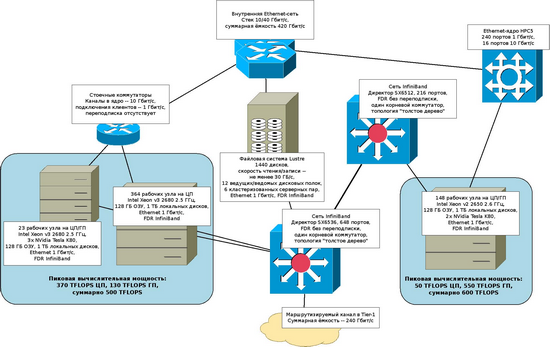

Вычислительные поля HPC4 и HPC5 обладают существенно различными характеристиками:

• на HPC4 используются двухпроцессорные платформы на базе процессоров Intel Xeon Haswell (v3), оснащённые 128 ГБ оперативной памяти на узел; основная часть поля ориентирована на расчёты, требующие только центральных процессоров, однако 23 узла дополнительно к Intel Xeon оснащены графическими ускорителями NVidia Tesla K80, позволяющими производить гибридные расчёты для задач, которым требуются и мощные центральные процессоры;

• на HPC5 же вычислительное поле несёт на себе по два ускорителя NVidia Tesla K80 (что обеспечивает однородность поля графических карт на HPC4/HPC5), но платформа базируется на Intel Xeon Ivy Bridge (v2) и предназначена, в основном, для последовательных и параллельных расчётов с использованием только мощностей GPU.

Дополнительно к этому, вычислительное поле HPC4 спроектировано максимально близким к основной части вычислительных ресурсов Tier-1 (в том числе, оснащено сравнительно ёмкими жёсткими дисками, что нехарактерно для HPC), а InfiniBand-фабрика оснащена трансляторами протокола IP-over-InfiniBand в TCP/IP и соединена 160-гигабитной магистралью с корневым коммутатором внутренней сети Tier-1, что позволяет совершенно прозрачным образом выделять ресурсы суперкомпьютера для пользователей Грид по предварительному запросу.

Кластер НРС4 состоит из:

364 вычислительных узла по 2 процессора Intel Xeon E5-2680 v3 (12 cores, 2.5GHz, 120W TDP) — всего 728 процессоров, 8 736 ядер, пиковая производительность — 370 Тфлопс

23 вычислительных узла по 2 процессора Intel Xeon E5-2680 v3 (12 cores, 2.5GHz, 120W TDP), по 3 ускорителя вычислений Supermicro NVIDIA Tesla K80 24GB GDDR5 PCIe 3.0 — всего 46 процессоров, 552 ядра, 69 ускорителей, пиковая производительность — 130 Тфлопс

Кластер НРС5 состоит из:

148 вычислительных узлов V-Class V200F2:

2 x Intel® Xeon® E5-2650 v2 (8 ядер, 2,6—3,4 ГГц)

2 x NVIDIA® Tesla™ K80 (4992 ядра CUDA, 1,87 Тфлопс DP, 24 ГБ GDDR5, 480 ГБ/с)

18 944 ГБ совокупной оперативной памяти, 74 000 ГБ совокупного локального дискового пространства

Системная сеть FDR InfiniBand 4x — топология Fat Tree с полной бисекцией

Управляющая и сервисная сети — 1/10 Gigabit Ethernet, 8 управляющих узлов V-Class V200FS. Энергопотребление вычислителя — 155,8 кВт

Пиковая производительность — 602,7 Тфлопс: 49,2 Тфлопс CPU 553,5 Тфлопс GPU.

Архитектура и спецификация кластеров HPC4 и HPC5

Архитектура и спецификация кластеров HPC4 и HPC5

Архитектура и спецификация кластеров HPC4 и HPC5

Кластеры HPC4 и HPC5, занимают соответственно шестое и четвёртое места в 24-й редакции российского рейтинга суперкомпьютеров top50 (от 29.03.2016). После введения в строй кластеров HPC4 и HPC5, суммарная пиковая производительность суперкомпьютерных ресурсов ОВК составила 1400 ТФлопс.

Специалисты центра консультируют пользователей по использованию суперкомпьютерных ресурсов ОВК, установленному прикладному программному обеспечению и оказывают помощь в организации вычислительных процессов обработки, анализа и визуализации данных.

В 2011 году Курчатовский институт, совместно с Объединённым институтом ядерных исследований в Дубне (ОИЯИ), начал работы по проектированию двух центров уровня Tier-1 для БАК, совместно осуществляющих поддержку всех четырёх экспериментов: в НИЦ "Курчатовский институт" поддерживаются ресурсы для ATLAS, ALICE и LHCb, в ОИЯИ – для CMS. Опытно-конструкторские работы были поддержаны Министерством образования и науки РФ, они были полностью завершены к 2013 году с высокой оценкой экспериментов БАК и контролирующих органов, а также работающими прототипами центров уровня Tier-1 в обоих организациях. В течение следующих двух лет последние по согласованию с CERN и менеджментом Worldwide LHC Computing Grid были расширены до уровня 10% суммарной вычислительной мощности центров уровня Tier-1 на 2014 год, что позволило России завершить цикл предоставления вычислительных мощностей для физики высоких энергий и начать хранить свою часть сырых данных экспериментов БАК на ресурсах своего региона.

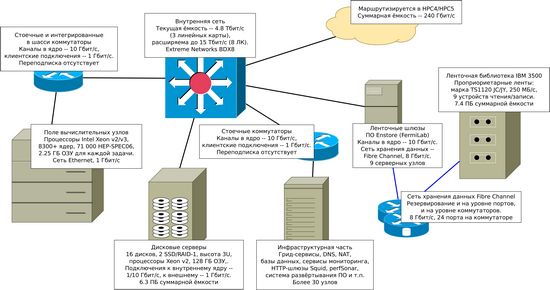

Архитектура Tier-1

Архитектура Tier-1

Архитектура Tier-1

В 2015 году Центр обработки данных в НИЦ "Курчатовский институт" имел следующие характеристики:

— вычислительная мощность – 71 000 единиц HEP-SPEC06;

— дисковая система хранения – 6.3 ПБ;

— ленточная система хранения – 7.2 ПБ;

— сеть между Tier-1 и другими Tier-1/Tier-0 – 10 Gbit/sec;

— сеть до остальных Tier-2 – не менее 5 Gbit/sec.

Грид-центр объединяет ресурсные центры уровней Tier-1 и Tier-2 глобальной грид-инфраструктуры WLCG Большого адронного коллайдера (CERN, Швейцария), которые поддерживают три из четырёх основных экспериментов, проводимых на БАК (ATLAS, ALICE и LHCB). Центр уровня Tier-2 предназначен для решения аналитических задач и обеспечения вычислительной мощности при моделировании методом Монте-Карло.

Центр уровня Tier-1 обеспечивает приём сырых данных, поступающих из центра уровня Tier-0 (CERN), и их хранение на магнитных дисках и лентах. Здесь производится первичная обработка данных, передача накопленной информации в центры уровня Tier-2 и хранение резервных копий данных, полученных в результате обработки сырых данных в центрах Tier-2. В центре Tier-1 можно проводить реконструкцию, симуляцию и анализ данных в автоматическом режиме по запросу внешних пользователей и систем планирования задач для каждого эксперимента.

Инфраструктура включает как ИКТ ресурсные центры, так и сетевые инфраструктуры (отечественные и международные – LHCOPN, LHCONE, GLORIAD, NORDUNET, GEANT, ESNet, CANARIE).

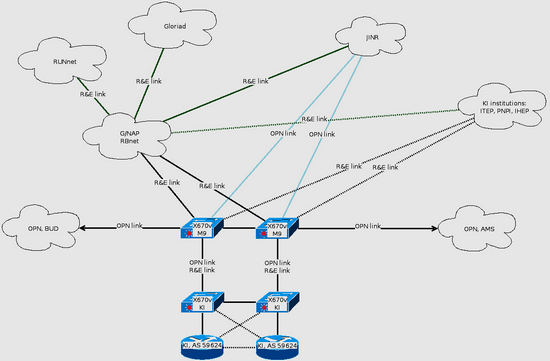

До 2012 года включительно вычислительные ресурсы НИЦ "Курчатовский институт" были исключительно клиентами различных сетей для науки и образования (GEANT, Gloriad, RBNet, РОСНИИРОС, RUNNet), однако с начала 2011 года велась работа по организации собственного сетевого отдела и выделения научно-образовательной связности в отдельную инфраструктуру, управляемую и сопровождаемую силами самого ОВК. В результате этих работ в 2013 году началась работа по организации каналов для LHC Optical Private Network, требующихся по условиям эксплуатации центров уровня Tier-1 для БАК, на арендованной канальной инфраструктуре, но с полностью собственным сопровождением выше второго уровня сетевой модели ISO/OSI.

В настоящее время Российская ИКТ инфраструктура научных исследований Мега-сайнс главным образом обеспечивает эксперименты БАК и де-факто определяется ресурсными центрами Т1-Т2 и сетевыми инфраструктурами НИЦ "Курчатовский институт" и ОИЯИ (более 90% ресурсов РДИГ - Российского ГРИД для интенсивных операция с данными).

Отечественные ядерно-физические установки класса Мегасайнс также будут находиться в сетевых инфраструктурах НИЦ "Курчатовский институт" (ПИК) и ОИЯИ (НИКА).

Поскольку для центров уровня Tier-1 является обязательным наличие выделенных каналов для передачи сырых данных из Tier-0 (CERN), ибо вторая копия данных должна как можно раньше быть доставлена и в Tier-1, чтобы всегда существовало два экземпляра экспериментальных наборов данных, то Tier-1 в Курчатовском институте и Дубне начали организовывать подключение к сети LHCOPN практически с самого начала опытно-конструкторских работ. В 2011-2012 году был организован канал ёмкостью 2.5 Gbit/sec, использующий в качестве транспорта инфраструктуру пан-европейской сети GEANT. В связи с распадом точки присутствия GEANT в Академии Наук и, как следствие, прекращением работы каналов в GEANT и LHCOPN, российские Tier-1 были вынуждены искать другие пути подключения к этой сети.

Начиная с 2013 года были инициированы работы по созданию отказоустойчивой сетевой инфраструктуры Москва – Амстердам – Будапешт – Москва с канальной ёмкостью 10 Gbit/sec. Такая география размещения каналов была выбрана потому, что вычислительный центр Tier-0 в CERN на тот момент уже был географически распределён между Женевой и Будапештом, а связность Амстердам-Женева была предложена для использования руководством CERN IT в качестве их вклада в российские центры уровня Tier-1. С 1 января 2014 года кольцо было введено в работу и функционирует по настоящий момент. На кольце обеспечена отказоустойчивость от всех фатальных единичных проблем с оборудованием и канальной инфраструктурой, ромбовидная структура каналов и 4 BGP-сессии обеспечивают перемаршрутизацию на время запланированных работ и аварий, политики распределения трафика для НИЦ "Курчатовский институт" и ОИЯИ построены так, что при нормальном режиме работы кольца обоим Tier-1 доступна полная полоса 10 Gbit/sec (используются оба сегмента).

В связи с невозможностью непосредственного использования европейской сети GEANT для организации доступа к сетям для науки и образования в дополнение к кольцевой инфраструктуре Москва–Амстердам-Женева-Будапешт-Москва емкостью 10 Gbit/sec организован дополнительный сетевой канал ёмкостью 10 Gbit/sec Москва – Амстердам с собственным коммутирующим оборудованием в обеих конечных точках для создания связности с сетями Gloriad, NetherLight, CANARIE, Internet2, ESnet и SURFsara. Закончены работы по организации канала ёмкостью 10 Gbit/sec до инфраструктуры NORDUnet (Москва-Финляндия), которая будет обеспечивать транзит трафика в северные регионы и значительную часть южно-восточной Европы.

С 2014 года НИЦ "Курчатовский институт" поддерживает инфраструктуру RU-VRF, являющуюся опорной точкой сети LHCONE (Large Hadron Collider Open Network Environment - предназначенной для обмена трафиком для БАК и некоторых других проектов, например, эксперимента Belle II, между центрами уровней Tier-1/Tier-2) в России: в 2014 году была пилотная фаза проекта, с начала 2015 года ОВК является оператором VRF и подключает к инфраструктуре LHCONE Грид-сайты подведомственных институтов Центра и ОИЯИ. Осуществляется транзит трафика в NORDUnet, CERN, CANARIE, ESnet и Internet2.

В 2015 - 2016 г.г. было проведено расширение канальной инфраструктуры. Усилиями НИЦ "Курчатовский институт" и ОИЯИ организованы и функционируют следующие каналы:

• Москва – Амстердам – Будапешт – Москва, 10 Gbit/sec, LHCOPN (Tier-0/1);

• Доступ в сеть LHCONE, 10 Gbit/sec (Tier-1/2);

• Канал Москва – Амстердам, 10 Gbit/sec (связность с отдельными Tier-1/2);

• Доступ через коммерческие сети к научным сегментам: 10 Gbit/sec (Tier-1/2)

• Канал НИЦ "Курчатовский институт" – ММТС-9 расширен до 8 x 10 Gbit/sec

• Точка обмена трафиком на ММТС-9 расширена до 2x10 Gbit/sec до G/NAP (РОСНИИРОС)

• Подключение институтов Центра к G/NAP: ИФВЭ – 10 Gbit/sec, ИТЭФ – 10 Gbit/sec, ПИЯФ – 1 Gbit/sec

• Возможность организации точки обмена трафиком на ММТС-9: до 80 x 10 Gbit/sec

Схема сети

Схема сети

Схема сети

В настоящее время связанность между оборудованием НИЦ "Курчатовский институт" и площадкой на ММТС-9 обеспечивается 8 каналами по 10 Gbit/sec, которые могут работать как в режиме резервирования, так и в режиме пропуска максимального трафика (до 80 Gbit/sec). Подключение к телеком узлу М9 и внешним сетевым инфраструктурам выполняется провайдерами (RBNet, RUNNet, ReTN) по отдельным договорам. Функционирует подключение Tier-2, входящего в ЦКП, к сети LHCOPN с использованием арендованной кольцевой инфраструктуры ёмкостью 10 Gbit/sec на каждом её участке. Связность между ММТС-9 и НИЦ "Курчатовский институт" позволяет подключать разные отрезки кольца к различному оборудованию на ММТС-9 и транспортировать различные VLAN до внешнего маршрутизирующего оборудования ЦКП.

Кольцевая структура Москва - Амстердам - Будапешт – Москва позволяет реагировать на пропадание канальной связности на любом отрезке в течение не более чем 1.5 секунды.

|