|

История

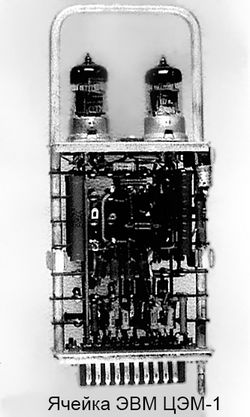

В 50-х годах прошлого столетия в НИЦ “Курчатовский институт” (тогда Лаборатория измерительных приборов АН СССР (ЛИПАН)), были сконструированы две цифровые электронные машины: ЦЭМ-1 и ЦЭМ-2.

В течение нескольких лет ЦЭМ-1 использовалась для решения разнообразных задач научной тематики института. Однако круг решаемых задач сильно ограничивала её относительно низкая скорость работы, и в связи с этим в 1954 г. было сделано предложение о создании новой ЭВМ — параллельного действия на новых элементах радиоэлектроники, что позволяло превзойти производительность ЦЭМ-1 в десятки раз. Руководил разработкой Б.И. Шитиков. Вновь разрабатываемой ЭВМ было присвоено название — ЦЭМ-2.

В течение нескольких лет ЦЭМ-1 использовалась для решения разнообразных задач научной тематики института. Однако круг решаемых задач сильно ограничивала её относительно низкая скорость работы, и в связи с этим в 1954 г. было сделано предложение о создании новой ЭВМ — параллельного действия на новых элементах радиоэлектроники, что позволяло превзойти производительность ЦЭМ-1 в десятки раз. Руководил разработкой Б.И. Шитиков. Вновь разрабатываемой ЭВМ было присвоено название — ЦЭМ-2.

Несмотря на все достоинства конструкции ЦЭМ-2, её серийное производство не было рекомендовано комиссией, поэтому в дальнейшем в ИАЭ использовались основные линейки отечественных серийных компьютеров – М20, БЭСМ-6, Эльбрус-1К-Б.

В декабре 1959 года ЭВМ М-20 была принята Государственной комиссией, а с середины января 1960 г. ЭВМ начала эксплуатироваться в промышленном режиме в четыре смены. В 1965 году была запущена вторая ЭВМ М-20, а в в сентябре 1965 года был образован Отдел электронно-вычислительных машин с коллективом в 100 человек. Четыре смены по 10 человек обслуживали две ЭВМ М-20 расположенные в 101 здании. В 1967 году была запущена в эксплуатацию М-220.

В 1969 г. появилась первая ЭВМ БЭСМ-6. Появление БЭСМ-6 стимулировало значительный рост работ по моделированию физических и технологических процессов. На ней решались задачи фундаментальной и прикладной физики, реакторные задачи, моделировалось поведение плазмы. Рост числа задач и пользователей быстро исчерпал возможности машины, и в 1974 была запущена вторая ЭВМ БЭСМ-6, а к концу 1977 года Вычислительный Центр обслуживал уже более 1000 пользователей.

Проводились уникальные разработки как в области оборудования, так и в области программного обеспечения. В частности, был разработан контроллер магнитных дисков, который обеспечил возможность объединения ЭВМ БЭСМ-6 в единый комплекс. В 1977 г, под руководством И.Г. Пасынкова, была создана "Диалоговая Мониторная Система (ДИМОН)", революционное по тем временам решение, которое позволило перейти от работы с перфокартами к работе с мониторами. Совместно со специалистами ряда организаций, была разработана отечественная диалоговая единая мобильная операционная система ДЕМОС, в которой изначально были заложены сетевые принципы. Разработчики ДЕМОС были награждены в 1988 году премией Совета министров СССР по науке и технике.

В 1980-х гг в Институте появились две более производительные ЭВМ Эльбрус-1К-Б и 2 ЭВМ ЕС-1066, которые были введены в строй и обеспечили пользователей ВЦ необходимыми в то время дополнительными ресурсами, поскольку мощностей БЭСМ уже крайне не хватало. А в конце 80-х — начале 90-х годов в КИАЭ появились зарубежные машины Convex и MicroVAX. Появление этих машин дало толчок к активному освоению учеными UNIX-подобных систем, переводу на эти системы значительного количества расчетных програм (например расчет пристеночной плазмы в реакторе ИТЭР). На машинах MicroVAX активно развивались сетевые технологии (сервера только появившейся в это время электронной почты).

Начиная с последней декады 20-го столетия деятельность ВЦ очень сильно переориентировалась в сторону сетевых приложений, поскольку в СССР благодаря усилиям многих команд (в том числе и сотрудников ВЦ КИАЭ под руководством А.А.Солдатова) появилась возможность наладить сетевую связность с внешним миром: в августе 1990 года окончательно сложилось ядро сети Демос/Диалог/КИАЭ, работающее на протоколе UUCP, а в период с 12 по 19 августа было организовано подключение к ресурсу fuug.fi. Вскоре был зарегистрирован домен .su и события начали разворачиваться очень стремительно, приведя к переходу от роста сети Internet внутри СССР к её слиянию со всей международной сетью.

При определяющем участии специалистов Курчатовского института в 1990 году была создана сеть РЕЛКОМ, которая объединила около 50 научных организаций страны. Созданная сеть вскоре получила выход во все мировые компьютерные сети и стала первой в СССР публичной компьютерной сетью, открывшей доступ к мировым информационным ресурсам и информационному обмену для всех желающих.

По заказу Минатома РФ в 1995 г. специалистами ИВК совместно с АООТ "Релком" создана информационно-телекоммуникационная система Российской части проекта Международного термоядерного экспериментального реактора (ITER). Она эксплуатировалась до конца мая 1999 года и объединила участников проекта ITER (НИКИЭТ, ИЯС РНЦ КИ, НИКИМТ – Москва, НИИЭФА и ВНИПИЭТ – Санкт-Петербург) цифровыми каналами связи с пропускной способностью 2.048 Мбит/с (E1), а также обеспечила обмен научными данными (включая тексты, графику, программы и т.д.) между собой и on-line доступ к мировым научным информационным массивам сети Internet. Общий потребляемый трафик всеми участниками проекта составлял ~ 17 Гбайт в месяц.

В 1996 г. специалистами ИВК, АОЗТ "Сатис-ТЛ-94" (организованным на базе Радиотехнического института им. академика А.Л. Минца) и ЗАО "Элекон" (г. Фрязино) на территории Центра построен телепорт РНЦ "Курчатовский институт", положивший начало развитию спутниковой сети связи, предназначенной для обеспечения доступа в международную сеть телемедицины и организации доступа в глобальные телекоммуникационные сети по спутниковым каналам.

В 1992 г. при непосредственном участии сотрудников Центра был создан Российский научно-исследовательский институт развития общественных сетей (РосНИИРОС). Результатом совместной деятельности РосНИИРОС и РНЦ "Курчатовский институт" стала крупнейшая в России научно-образовательная сеть RBNet, объединившая многие научные и образовательные организации – от общеобразовательных школ до крупнейших научных центров. Сеть RBNet была построена как базовая транспортная магистраль, обеспечивающая связность многочисленных сетевых сегментов, которые обслуживали различные группы пользователей, относящихся к сфере науки и образования РФ. RBNet представляла собой высокоскоростную IP-сеть, объединявшую федеральные округа и охватывала около 50 регионов РФ. Базовые узлы, распологались в городах: Москва, Санкт-Петербург, Ростов-на-Дону, Самара, Нижний Новгород, Казань, Екатеринбург, Новосибирск, Иркутск, Хабаровск, Обнинск. Канальная инфраструктура сети RBNet обеспечивалась двумя крупнейшими российскими операторами связи – компаниями "Транстелеком" и ОАО "Ростелеком".

Инфраструктура сети RBNet была задействована для реализации международного проекта GLORIAD. GLORIAD (или ГЛОРИАД) – глобальная высокоскоростная сетевая инфраструктура, специально предназначенная для телекоммуникационного обеспечения передовых научных проектов, поддерживалась консорциумом 11 стран: США, Российской Федерации, Китайской Народной Республики, Кореи, Нидерландов, Канады и стран Северной Европы (Дании, Швеции, Норвегии, Финляндии и Исландии), каждая из которых вносила свой вклад в построение глобальной оптической сети кольцевой топологии. Со стороны России координатором проекта стал Российский научный центр "Курчатовский институт". Благодаря активной работе участников ГЛОРИАД со стороны России, Нидерландов и США в мае 2007 года учёные продемонстрировали новый метод передачи больших (терабайтных) объёмов научных данных на межконтинентальном расстоянии. В январе 2007 года РНЦ "Курчатовский институт" обеспечил создание канала STM-64 (10 Гбит/с) между Москвой и Амстердамом. Это и дало возможность для эксперимента Teraflow установить специальный оптический канал ("lightpath"), соединяющий Москву (MoscowLight) и Чикаго (StarLight) через Амстердам (NetherLight).

РосНИИРОС являлся также базовой организацией администрирования национального домена .RU.

В 2003 году Курчатовский институт начал работы по проектированию, введению в строй и поддержке центра уровня Tier-2 (входящего в распределённые Грид инфраструктуры Russian Data-Intensive Grid и Worldwide LHC Computing Grid). Это стало новой вехой в истории Центра обработки данных, поскольку дало новый толчок к эволюции как вычислительных ресурсов и подходов к их созданию, сопровождению и модернизации, так и сетевых ресурсов (поскольку были необходимы хорошие каналы данных до других центров распределённой инфраструктуры компьютинга для Большого Адронного Коллайдера, разнесенной практически по всему земному шару). Запущенный в 2004 году центр уровня Tier-2 состоял из 25 вычислительных узлов на базе процессоров Intel Xeon, сервера хранения данных ёмкостью 240 ГБ, инфрастуктурных и Грид-сервисов, построенных на базе стека ПО LCG-2. Для выхода в Интернет использовались ресурсы RBNet и Relcom.

2005 год ознаменовался переводом (вернее, созданием нового центра, включая разработку нового ПО и операционных процедур, и прекращением работы старого) национального центра по выдаче цифровых X.509-сертификатов из НИИЯФ МГУ в НИЦ “Курчатовский институт” (работы по его вводу в промышленную эксплуатацию велись с середины 2003 года): центр был аккредитован группами EUGridPMA и IGTF, первый пользовательский сертификат был выпущен 19 августа 2005 года). С тех пор было выпущено более шести тысяч сертификатов, из которых порядка семисот составляют на данный момент активное подмножество), центр обслуживает весь российский регион.

Около 2006 года развернулись работы по суперкомпьютерному направлению. Первый суперкомпьютер из 1024 двухпроцессорных узлов на платформе Intel Xeon был собран и запущен в 2007 году. Именно в это время прочно закрепились две аббревиатуры: HPC (High-Performance Computing, высокопроизводительные вычислительные ресурсы), соответствующие параллельным вычислительным кластерам, и HTC (High-Throughput Computing, вычисления с высокой пропускной способностью) – это Грид-системы, обрабатывающие потоки одно- или многоядерных задач, не выходящих за пределы одного вычислительного узла. Появление новой области – Грид-систем – способствовало возрождению традиционных для ВЦ работ по проектированию, поддержанию и модернизации централизованных вычислительных ресурсов.

XXI век застал значительные изменения в парадигмах построения больших систем хранения и обработки данных. Если до этого суперкомпьютеры были сильно-интегрированными системами, реализованными на специализированной аппаратной базе, то концепция Beowulf в HPC и сами Грид-системы в HTC представляют другой взгляд на архитектуру таких комплексов. В ходе их построения используются, фактически, массово-производящиеся вычислительные узлы (серверного класса, чтобы обеспечить требуемую надёжность и производительность), но они объединяются между собой в сетевую инфраструктуру и, что главное, не делается предположений о том, что все узлы системы будут работать совсем без или с крайне редкими сбоями. Более того, делается даже обратное предположение, которое сродни закону Мёрфи: всё может ломаться, и общая система проектируется так, чтобы зарезервировать единые точки отказа, а с остальными сбоями работать "в штатном режиме функционирования".

Дальнейшее развитие компьютерных технологий вообще и HPC/HTC-областей, в частности, показало крайнюю жизнеспособность такого подхода и отличную масштабируемость систем, использующих его, вплоть до уровня десятков петафлопс. В качестве примера можно привести инфраструктуры таких гигантов, как Google, Yahoo!, Amazon, Yandex, которые построены опираясь именно на эту парадигму проектирования.

Смена компьютерных технологий и участие в ГРИД-инфраструктуре БАК предъявили новые требования к инженерной инфраструктуре. В 2010 году в НИЦ "Курчатовский институт" был создан Центр обработки данных (ЦОД) Курчатовского комплекса НБИКС-природоподобных технологий нового поколения, преобразованный в 2018 г. в Объединенный вычислительный кластер (ОВК), обеспечивающий высокопроизводительную платформу для моделирования и анализа данных.

|